NECは2023年7月6日、記者説明会を開催。日本市場向け生成AIを開発・提供開始すると発表した。

「我々は今回、LLM(大規模言語モデル)の日本市場向けモデルを開発した。一言で言うと、Readyな(準備ができている)状態だ」。会見の冒頭、NEC Corporate EVP 兼 CDOの吉崎敏文氏はこうアピールした。

NEC Corporate EVP 兼 CDOの吉崎敏文氏

NECが開発したLLMは、独自に収集・加工した多言語データを利用したファウンデーションと呼ばれる汎用的なモデルだ。主に2つの特徴があるという。

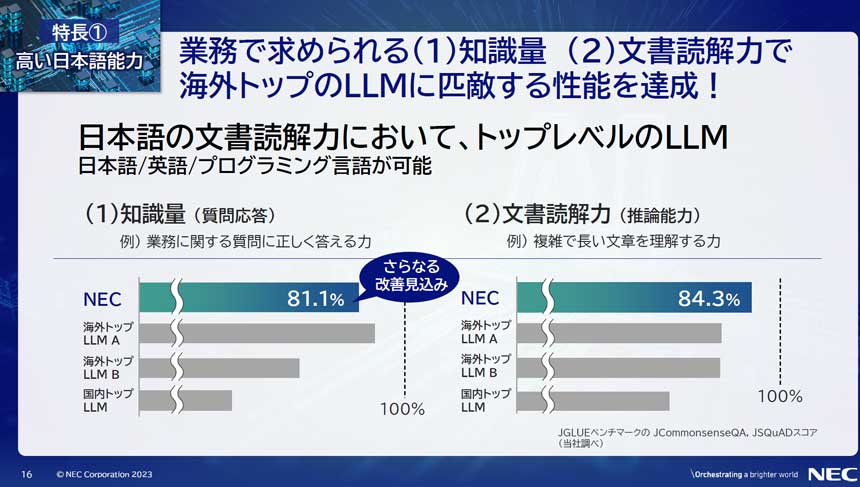

1つめが、高い日本語能力だ。

LLMを実際の業務で利用するには、日本語に関する知識量および文章読解力の点で高い性能が求められる。自然言語処理分野で標準的なベンチマークであるJGLUE(日本語言語理解ベンチマーク)を用いてNECが行った評価では、知識量に相当する質問応答で81.1%、推論能力に相当する文章読解では84.3%と、いずれも世界トップレベルの性能を達成した。

日本語の知識量と文書読解力で高い性能を実現

NEC Corporate EVP 兼 CTOの西原基夫氏によると「さらに性能の改善が進んでいる」という。

NEC Corporate EVP 兼 CTOの西原基夫氏

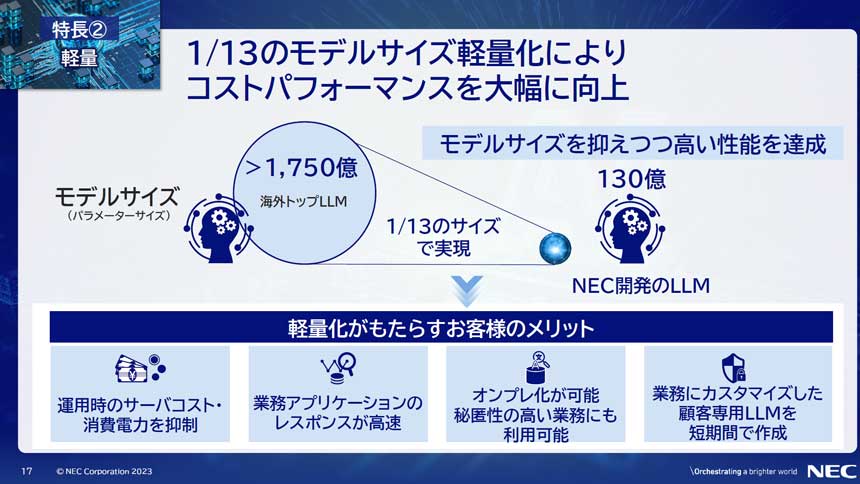

2つめの特徴が、軽量であることだ。

NECの独自技術により、モデルサイズ(パラメーターサイズ)を130億と、海外の有力なLLMの1/13に抑えている。高い性能を有するLLMはGPUを8枚必要とするのに対し、NECのLLMはGPUを1枚搭載した標準的なサーバーで動作することが可能だ。

海外の有力なLLMの1/13の軽量化を実現

NECでは、LLMの性能がパラメーターサイズのほか、学習に使われる高品質なデータの量や学習時間に左右されることに着目。パラメーターサイズをGPU1枚で動作する範囲に抑えたうえで、多量のデータと膨大な計算時間をかけることで、モデルサイズを抑えつつ高い性能を実現した。これにより、LLMを組み込んだ業務アプリケーションがレスポンスよく動作し、運用時のサーバーコストや電力消費が抑えられるという。

このLLMは、今年3月から全面稼働を開始したAI研究用スーパーコンピューターを活用し、約1カ月という短期間で構築した。NEC社内では今年5月から業務に活用しており、利用者数は約2万人、1日あたりの利用回数は約1万回にのぼる。すでに、資料作成時間の50%削減、社内システム開発におけるソースコード作成業務の効率化による工数の80%削減などの成果が出始めているという。