96基のNVIDIA H100 GPUを搭載、GPUサーバー間の通信にはInfiniBandを活用

ただTD-1のような大規模AIを動かすには、潤沢なコンピューティングリソースを用意する必要がある。そこでTuringが開発したのが、専用GPUクラスター「Gaggle Cluster」だ。

Gaggle Clusterは、96基のNVIDIA H100 GPUを搭載。GPUサーバー間の通信にはInfiniBandを用いることで、複数のGPUを同時使用する際にボトルネックとなっていたサーバー間の通信速度の制約を最小化しているという。

また、データの記録・消去を行えるフラッシュメモリ(SSD)を活用した「オールフラッシュ分散ストレージ」を採用することで、分散学習の効率化・データの読み書きの高速化を実現させているとのことだ。

専用GPUクラスター「Gaggle Cluster」の概要

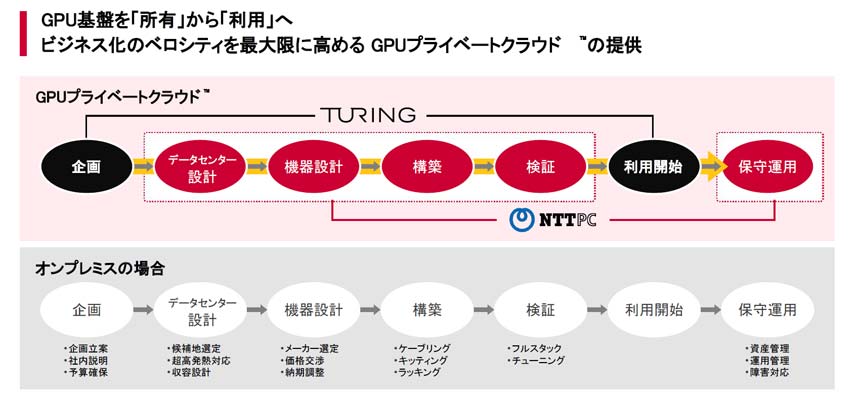

このGaggle Clusterを支えているのが、NTTPCの「GPUプライベートクラウド」である。自社利用に最適化された“フルスクラッチ”の AIプラットフォームを構築・利用可能なサービスだ。

「オンプレミスでGPU基盤を作ろうとすると、データセンター設計から機器設計・構築までにかなりのコストと時間がかかるが、これを我々が代行する。これにより、Turingは自動運転技術の開発にリソースを投入できるようになる」とNTT PC 代表取締役社長の工藤潤一氏は説明した。保守・運用に関してもNTTPCが担う。

GPUプライベートクラウドの概要

なお、NTTグループのコーポレートベンチャーキャピタル(CVC)であるNTTドコモ・ベンチャーズは今年4月、このTuringに出資を行っている。同社 代表取締役社長の安元淳氏は「ドコモグループとしてモビリティビジネスに力を入れていくなかで、3~5年後に新たなB2Cサービスを一緒に実現できるのではないかと考え、中長期的な視点で出資を決めた」とその狙いを語った。

Turingへの出資

Turingは、2025年12月に実証実験を実施する予定で、東京の複雑な道路を人間の介入なしで30分以上走行できるような自動運転モデルの開発を目指すとしている。