より多くのデータを、より高速に処理したいという需要はとどまることを知らない。そのニーズに合わせてコンピューターを構成する各要素は進化を続けてきた。しかし、1つの集積回路に集約できるトランジスタの数は約2年ごとに2倍になるという「ムーアの法則」は限界が見えつつある。コンピューティング環境が物理のくびきから開放され、ソフトウェア化・抽象化されて柔軟になることでIT環境はさらに進化したが、CPUにかかる負荷は高まる一方だ。

そこで、CPUが担っていた処理の一部を専用ハードウェアに肩代わりさせる、いわゆる「オフロード」により、全体の性能を向上させる取り組みが広がってきた。典型的な例がGPUだ。かつてCPUにとって大きな負担となっていた描画処理を専用のチップに肩代わりさせることでシステム全体の高速化を図るもので、今やAI/MLなどの計算には欠かせない存在となっている。

そして今、新たなボトルネックとなっているのが、ストレージやネットワーク転送、セキュリティ制御といったデータ処理だ。長らく物理的な機器に縛られてきたストレージやネットワークの領域でも、Software Defined Storage(SDS)やSoftware Defined Network(SDN)が広がり、拡張性や柔軟性が高まっているが、これに伴いより多くのデータ処理が必要になった。ネットワークインフラも高速化が進み、今や10Gbpsや25Gbpsは当たり前、100Gbpsや400Gbpsも視野に入るようになったここ数年で、ボトルネックはいよいよはっきりしてきた。

「かつてネットワークやストレージの速度は、CPU処理の速度に比べそれほど速くはなく、扱うデータ量も少なかったため、CPUが片手間で処理することもできました。しかし、世の中の変化に伴い、はるかに多くのデータを処理しなければならなくなった今、こういったインフラ周りの処理を高速化するハードウェアが求められています」

NVIDIAのソリューションアーキテクチャ&エンジニアリング部ディレクター、アヴィ・テルヤス氏はこう指摘する。GPUを通して高速なAI/ML処理を支援してきたNVIDIAだからこそ、ストレージやネットワークがボトルネックになっていることを肌感覚で理解しているという。

NVIDIA ソリューションアーキテクチャ&エンジニアリング部ディレクター アヴィ・テルヤス氏

このボトルネックを解決する切り札として注目されているのが「DPU」だ。

複雑なデータ周りの処理を肩代わりし、全体の性能向上を実現する「DPU」

DPU(Data Processing Unit)は、文字通り、ストレージのI/Oやネットワーク処理、ファイアウォールや暗号化をはじめとするセキュリティ処理など、データのやりとりにまつわるさまざまな処理を高速化する専用ハードウェアだ。

「VXLANやvSwitchといった処理をすべてCPUで行うと、そこがボトルネックになります。DPUはSDSやSDNの処理をすべてオフロードでき、CPUは仮想マシンやコンテナ周りの計算だけに専念できます」(テルヤス氏)

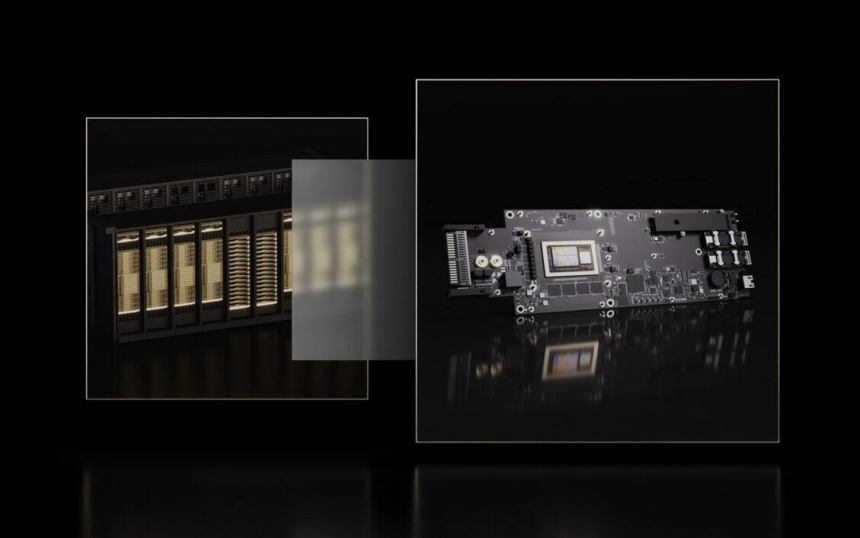

さまざまな企業がこのDPUをリリースする中、GPU市場で確固たる実績を築いてきたNVIDIAも、DPU製品「NVIDIA BlueField-2 DPU」を提供している。NVIDIA ConnectX-6 Dx相当のNICによって最大200Gbpsの通信が可能なほか、目的別に複数のアクセラレーションエンジン、つまり特定の用途に特化した高速処理エンジンを搭載しており、さまざまなデータ処理をオフロードできる。

Armコアによる柔軟な制御と専用エンジンによる高速な処理を両立させるNVIDIA BlueField-2 DPU

DPUのポイントの1つは、こうした処理が「プログラマブル」であることだ。BlueField-2もプログラマブルなArmコアCPUを搭載しており、用途に合わせて柔軟にコントロールできる。

ただ、データの処理そのものはあくまでアクセラレーションエンジンが担うため、Armコアが全体の処理性能を左右し、パフォーマンスが落ちるといったことはない。「Arm搭載という言葉だけに引っ張られ、DPUは性能が遅いのではないかというイメージを持つ方もいますが、それはまったくの誤解です」(テルヤス氏)