生成AI開発を支える高性能GPUサーバーに「液体冷却(液冷)」が急速に普及している。消費電力と放熱量の増大によって、空冷の限界が見えてきたためだ。

液冷は、空気よりも熱伝導率が高い水などを使って放熱する方式で、空冷に比べて冷却効率が高い。GPUの高密度化と、A Iインフラの省エネ化に不可欠な技術として期待が集まる。

GPUサーバー間をつなぐネットワークも、このトレンドと無縁ではいられない。GPUクラスターを構成するバックエンドネットワークでは今年、400GbEから800GbEへの移行がスタートする。それとともに「液冷スイッチ」の導入が始まりそうだ。

いち早く液冷スイッチを市場投入したのが、台湾のホワイトボックススイッチメーカー、UfiSpaceだ。AVP of Research & Developmentを務めるレイ・チャン氏によれば、複数のユーザーがすでに液冷方式を採用した800GbEスイッチを検証中という。

UfiSpace AVP of Research & Development レイ・チャン氏(Ray Chang)

最新GPUシステムは液冷が前提

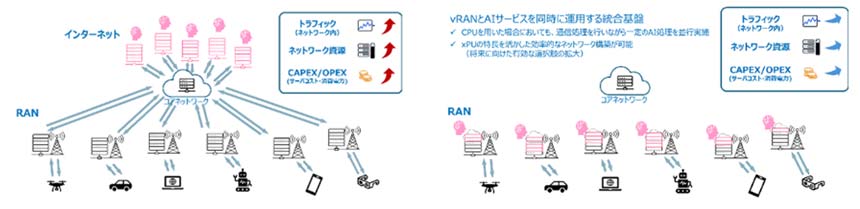

液冷方式の導入はGPUサーバーから始まったが、AIデータセンター(DC)においては今後、ネットワークやストレージも含めたシステム全体で、液冷を前提とした冷却システムの統合が進む可能性がある。UfiSpaceが液冷スイッチを市場投入した狙いもここにある。「GPUサーバーで液冷が使われている割合は現在20%ほどで、今後増えることは確実。将来的には、GPUとネットワーク機器の冷却システムを統合するソリューションの必要性が高まる」と予想する。

その先例が、エヌビディアの最新GPUアーキテクチャ「Blackwell」を採用した「NVIDIA GB200 NVL72 Platform」だ。液冷を前提に設計されており、サーバーベンダー各社が今年、これを搭載したシステムを出荷する計画だ。

消費電力が非常に大きいNVIDIAGB200は、空冷での排熱が現実的に難しい。加えて、NVL72が採用している液冷システムは、従来の空冷アーキテクチャと比べて収益性は40倍、エネルギー効率は25倍にも達するとエヌビディアは発表している。

さらに、GPUだけでなくネットワーク、NVswitchにも液冷を採用することで、高密度を実現している。NVSwitchは大規模なAI学習基盤において、数十から数百のGPUを相互接続して1つの仮想GPUとして機能させるために使われるスイッチチップだ。

また、エヌビディアは、ラック間をまたいで大規模GPUクラスターを構築する場合に使われるInfiniBandスイッチにも液冷方式を採用することを発表している。2025年3月に、800GbpsのInfiniBandを144ポート搭載するNVIDIA Quantum-X Photonics InfiniBandスイッチを発表。液冷設計を採用した同製品を、2025年後半に発売する予定だ。