AIワークロードに特化 DPUから「SuperNIC」へ

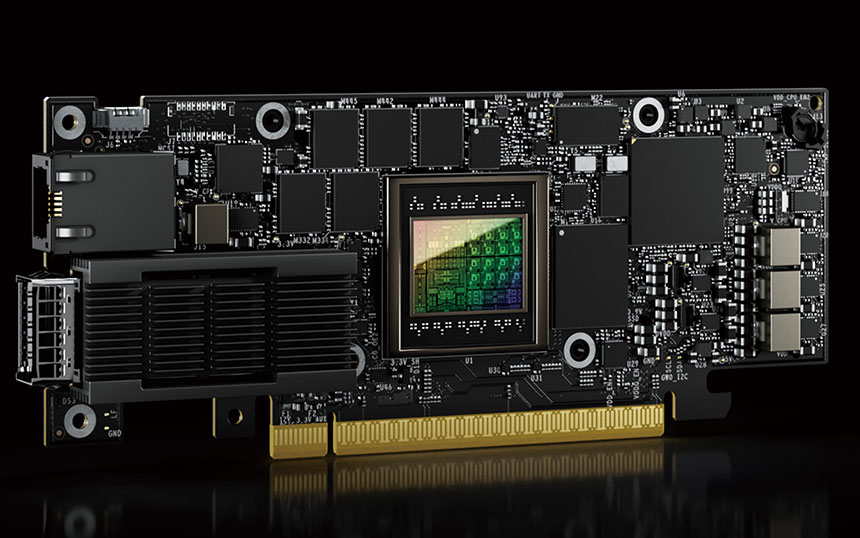

このほかストレージプロトコル処理も担うなど多用途化が進んだDPUだが、ここにきて新たな形態変化が起きている。AI計算に特化したアクセラレーター「BlueField-3 SuperNIC」という派生型が登場したのだ。

DPU技術をベースとしてAIワークロード向けに設計された「NVIDIA BlueField-3 SuperNIC」

ここまで見てきたように、BlueField DPUのオフロード機能は、データセンター内の「North-South」通信を主ターゲットに強化・多様化してきた。だが、AIデータセンターにおいてはGPUサーバー間の「East-West」通信の高速化・効率化こそが最大の焦点だ。

図表 Optimized Networking for AI Cloud Data Centers

SuperNICは、この要請に応えて誕生した“コンパクト版DPU”だ。愛甲氏によれば、「DPU技術を基盤としながら、AIの計算処理に特化して最適化された。特に、GPU間の東西通信を効率化するためにサイズやパワー消費を最適化している」。BlueField-3 DPUは多機能化によって消費電力が増えた結果、外部電源が必要となったが、「SuperNICは、PCIスロットの75Wだけで動作するよう設計されている」。

当然、AIデータセンターに必要な“DPU由来の機能”はぎっしりと詰め込んでいる。SuperNICは、AI向けネットワーキングプラットフォーム「NVIDIA Spectrum-X」の一部として動作し、ネットワーク帯域効率の向上に必須のAdaptive Routingや、高度な輻輳制御、Performance Isolation等の機能を提供することで、AIワークロードのネットワークパフォーマンスを大幅に向上させる。この輻輳制御によって、マルチGPU環境で使われるNCCL AllReduceの帯域幅は、従来のイーサネットと比較して2.5倍に向上するという。

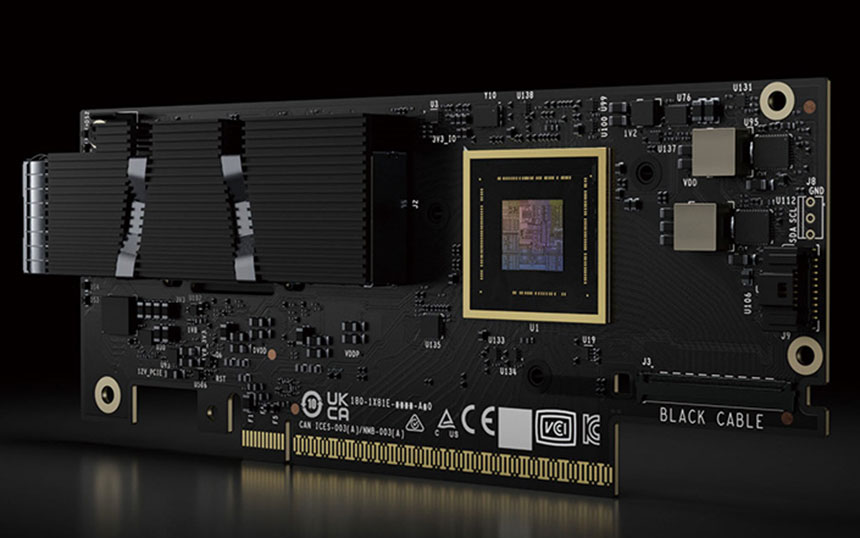

このように、多用途化の歴史を経てきたDPUは今、用途特化型のSuperNICへと進化を遂げ、AIインフラに不可欠なコンポーネントへと生まれ変わった。“本家”であるDPUに先駆けて、AIデータセンターで導入が始まっている800Gbpsにいち早く対応した「ConnectX-8 SuperNIC」もすでに登場している。

最大800GbpsのInfiniBandとイーサネットネットワーキングの両方をサポートする「NVIDIA ConnectX-8 SuperNIC」

エヌビディアは今後、400Gbpsから800Gbpsへの移行をはじめとするAIインフラで求められるニーズには、特化型のSuperNICで迅速に対応していく考えだ。クラウドインフラや通信事業者ネットワークも含めて広範な用途・ニーズに応えるDPUと合わせて、SuperNICの進化からも目が離せない。

<お問い合わせ先>

エヌビディア合同会社

お問い合わせ窓口:https://nvj-inquiry.jp