NRIセキュアテクノロジーズは2024年6月19日、「AIセキュリティ統制支援サービス」のラインナップの1つとして、生成AIを活用したシステムを対象にセキュリティ監視を行う「AI Blue Team」の提供を同日開始したことを発表した。

LLM(大規模言語モデル)などの生成AIを情報システムに組み込んで業務効率化や新規サービスに活用する動きが急速に広がるなか、それらについてのセキュリティ対策が重要になっている。

生成AIのセキュリティリスクは多岐にわたり、攻撃者が入力プロンプトを操作して攻撃する「プロンプトインジェクション」、LLMに設定されていた指令や機密情報などを盗み出そうとする「プロンプトリーキング」等の攻撃の標的となりうる脆弱性のほか、AIが事実に基づかない情報を生成する「ハルシネーション」や、不適切なコンテンツの生成、バイアスリスク等の生成内容の信ぴょう性の観点や、予期せぬ機微情報の漏洩といったインシデント等がある。

同社は、こうしたリスクから導入企業のシステムを保護する仕組みを独自に開発し、アプリケーションとして同サービスに組み込んだという。

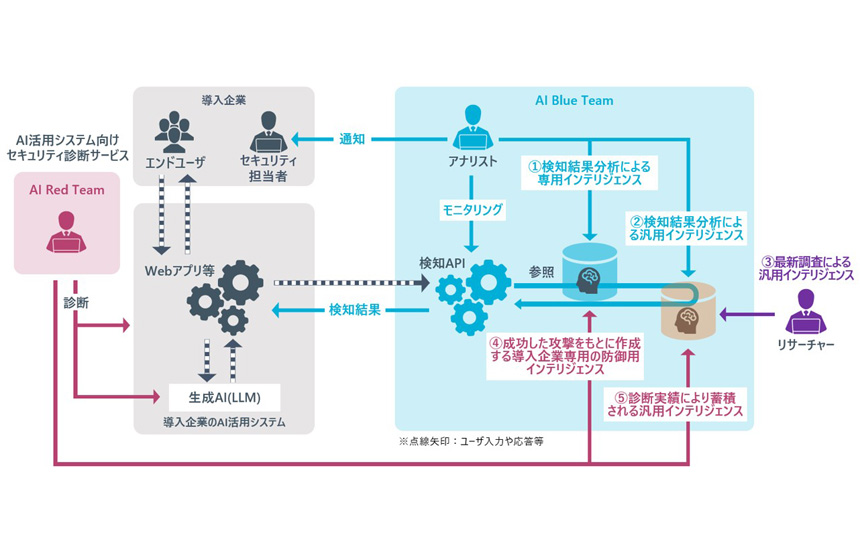

AI Blue TeamとAI Red Teamを併用した生成AI活用システムのセキュリティ強化策

AI Blue TeamとAI Red Teamを併用した生成AI活用システムのセキュリティ強化策

特徴は2点あり、1点めは生成AI活用システムを継続的にモニタリングし、広範囲かつ最新のAIリスクを回避すること。監視対象となるシステムと生成AI間で行われる入出力の情報を、同サービスで提供する「検知API」に連携し、有害な入出力を検知した場合、導入企業の担当者に通知する。同社のアナリストによる攻撃傾向の分析も提供する。

2点めは、システム固有の脆弱性を防御し保護レベルを強化すること。2023年12月にリリースしたセキュリティ診断サービス「AI Red Team」でシステム固有の脆弱性を洗い出した上で同サービスを利用することで、汎用的なインテリジェンスとは別に、導入企業専用のインテリジェンスを蓄積し、固有の脆弱性を攻撃から防御しつつ、システム全体の保護レベルを一層強化することが期待できるとしている。