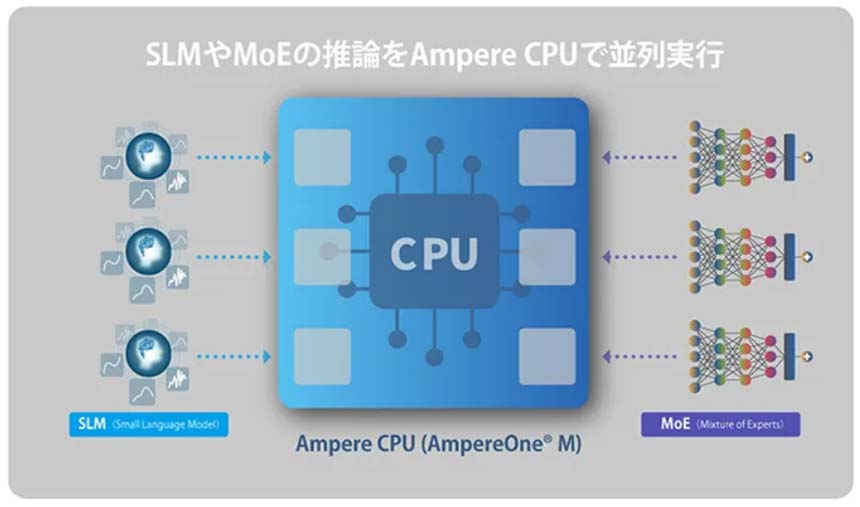

デバイスのコンピューティングパワーが増大するのに伴い、高度なAI処理をデバイス上で実行する“エッジAI”の活用シーンが広がっている。クラウド上で生成された学習モデルをエッジデバイスに実装し、現場で画像認識や異常検知等を行うことが可能だ。

AI処理は、センサー等から集められた膨大なデータを基に行う「学習」と、それにより生成された学習モデルを使って行う「推論」に分けられる。従来はどちらもクラウド上で行われていたが、最近では、IoTゲートウェイやエッジサーバー、さらにはエッジデバイス上に学習モデルを実装し、現場近くで推論を実行する形態が増えてきた。

潤沢なリソースが使えるクラウドではなく、なぜエッジで推論処理を行うのか。その理由は複数ある。

学習と推論の両方をクラウドで行う場合、推論を実行した結果をデバイス(=現場)に反映するのに遅延が生じる。学習に必要なデータをクラウドに送るために、上り通信の帯域が逼迫することもデメリットだ。また、クラウドとエッジをつなぐネットワークの品質が変動したり通信が途切れたりすると、AI処理を安定的に行えない。

推論をエッジ側に任せれば、これらの課題を解消できる。リアルタイム性が高まり、学習に必要なデータをエッジで集約してからクラウドに送ることで通信帯域も節約。さらに、クラウドと通信していないオフライン時にも、ローカルで推論処理を継続できる。

図表 学習と推論の分担の効果

このエッジAIを支えるのが、AIエンジンを搭載したチップセットだ。

スマートフォン向けプロセッサで市場シェア1位のクアルコムは現在、多様なIoTデバイスをターゲットにエッジAI用チップセットも展開している。クアルコム シーディーエムエーテクノロジーズ スタッフマネージャー マーケティングの泉宏志氏は、「モバイル向けチップの資産を活かして、Windows OS用、VR/AR用、ロボティクス用、ウェアラブル用、コネクテッドカメラ用のほか、幅広いIoTニーズに応えるチップセットを開発・提供している」と話す。

クアルコム シーディーエムエーテクノロジーズ

スタッフマネージャー マーケティング 泉宏志氏