CPU/GPUをアプリケーション処理やAIワークロードに集中させるために、ネットワークやストレージ、セキュリティ処理を一手に担う──。

データセンターネットワーキングで「DPU(Data Processing Unit)」が果たすこの役割が重要性を増してきている。とりわけ、AIデータセンターにおいてGPUの価値を最大化するには、DPUは不可欠な存在となりつつある。

DPU市場をリードしているのがエヌビディアの「NVIDIA BlueField DPU」だ。実はこの製品、生成AIが台頭する以前から、現代のAIデータセンターと似通った環境で性能・機能を磨き続けてきた歴史を持つ。その出自と進化の過程を紐解くと、「DPUがAIインフラに不可欠な理由」が見えてくる。

生成AI“前夜”に登場したDPU 超並列計算を支える技術とは

最初のDPUであるBlueField-2をエヌビディアが正式発売したのは2020年。そのターゲットは、スパコン/HPCだった。エヌビディア エンタプライズマーケティング シニア マーケティング マネージャの愛甲浩史氏は、同社が2020年に買収した「メラノックスが、スパコンのクラスターで長年使っていた技術をより汎用的に活用できるようにするため、Armコアを搭載した初期のBlueFieldを開発した」と振り返る。

エヌビディア エンタプライズマーケティング シニア マーケティング マネージャ 愛甲浩史氏

このBlueField-2のベースとなったスパコン向け技術の目的と、現在のAIデータセンターで使われるBlueField-3 DPUの目的は根本的に変わっていない。目指すのはどちらも、CPU/GPUの負荷軽減だ。

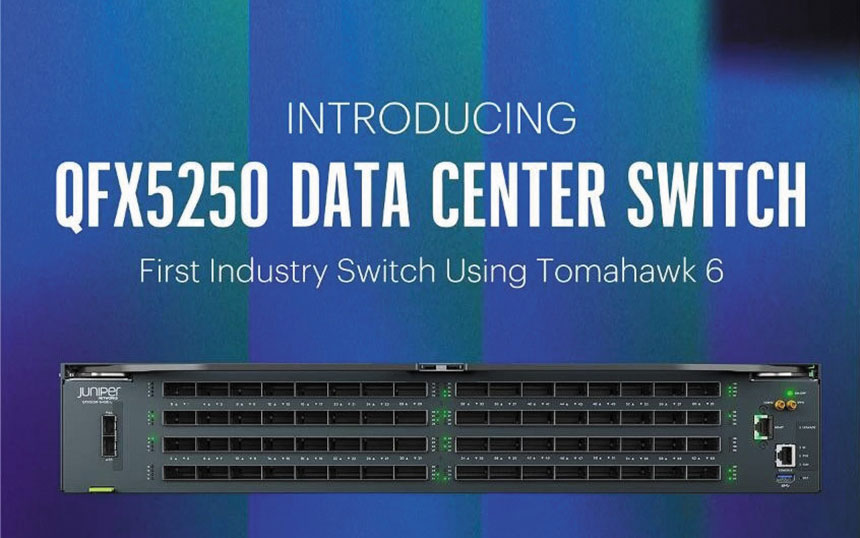

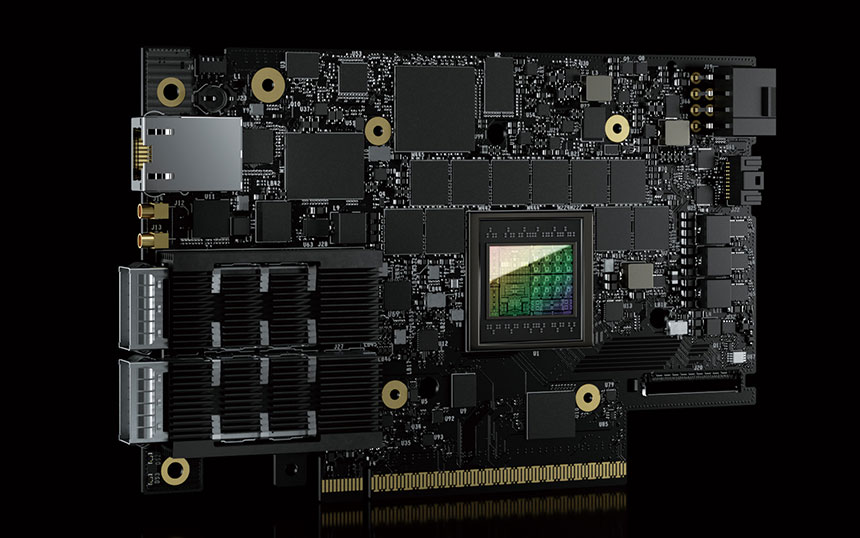

ネットワークやストレージ、セキュリティ、管理機能をオフロードし、データセンターのパフォーマンスを最適化する「NVIDIA BlueField-3 DPU」

膨大なデータと複雑な計算を高速に処理するスパコン/HPCは、複数のコンピューティングノードをネットワークで接続した「クラスター」で大量の計算処理を並列で実行する。これは、現代のAIデータセンターで「GPUクラスター」が行っているのと同じ仕組みだ。

スパコン/HPCの運用者は当然、CPUを本来の仕事である計算処理に専念させたいと考える。だが、クラスターを構成するためのネットワーク処理(ヘッダー処理やデータ分割など)がCPUに余計な負荷をかけてしまう。そこで、単に通信機能だけを備えていたネットワークインターフェースに、ネットワーク処理を行うオフロード機能を実装。さらに、ストレージ処理やセキュリティ機能も代行させて、CPUの負荷をより軽減できるように進化させた。2010年代に登場した高機能NIC(SmartNIC)も、CPUの負荷を減らすという点で同様のものであった。

このオフロード機能の活用範囲は徐々に拡大し、今ではクラウドインフラ、そしてAIデータセンターにも必要とされるようになった。そこで、より汎用性が高く、電力消費効率でも優位性を持つArmコアを搭載して「より広い分野で使えるようにした」のがBlueField DPUだ。2022年に登場したBlueField-3 DPUは400Gbpsをサポート。AIデータセンターで不可欠なRDMA/RoCEアクセラレーションや、SDN/NFV高速化などの機能も備える。

セキュリティ対策に活用するケースも増えている。ネットワークトラフィックの監視や暗号化、不正アクセスのブロックなどだ。CPUの負荷を軽減するために「従来は一部のデータしか監視していなかった環境でも、DPUならラインレートでのデータ検査も夢ではない」(愛甲氏)。さらに、「不審な兆候を検出した場合には、監視AIにデータを送って精密な診断を行うといった対処も可能だ。必要なら、DPU上で不正通信のブロックもできる」。監視、診断から対処までCPUに一切の負荷をかけずに行えるようになるのだ。