「多くの組織がAIを導入・展開しているが、そのAIをどのようにセキュアにするかという計画は持ち合わせていない」

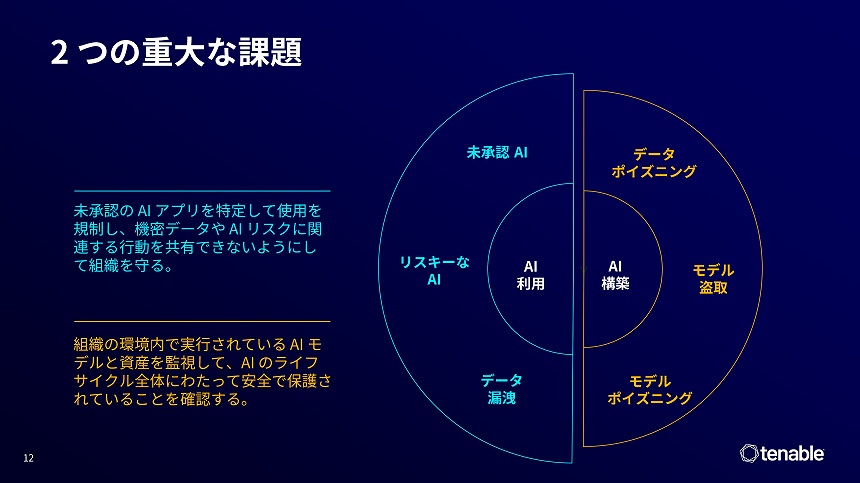

Tenableの日本法人であるTenable Network Security Japanが2025年9月26日に開催した記者説明会で、Tenable 最高製品責任者(CPO)を務めるエリック・ドーア氏は、エンタープライズAIの利用に伴うリスクについてそう切り出した。そのリスクは、AIの利用形態によって大きく2つに分かれるという。

Tenable 最高製品責任者(CPO)のエリック・ドーア氏

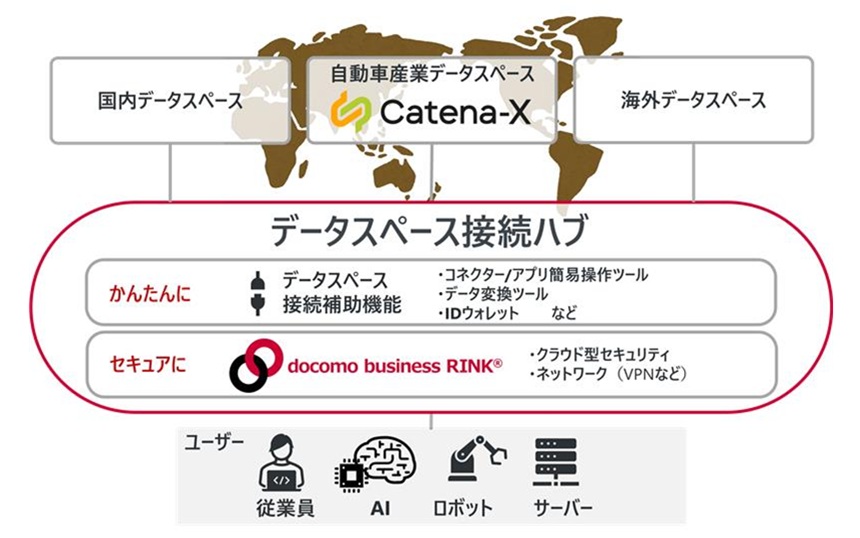

1つは、ChatGPTやMicrosoft Copilotのように、企業・組織の従業員が日常業務の中でAIサービスを消費する場合だ。本来アクセスすべきでないAI、承認されていないAIアプリケーションを利用する「シャドーAI」のリスクがあり、例えば、機密情報が含まれているデータを誤ってそうしたAIに提供してしまうといった事例が発生している。

もう1つは、企業・組織が独自にAIツールを構築するケースだ。この場合にも、AIの学習データに意図的に偽情報や悪意のあるデータを混入させる「データポイズニング」や、モデルそのものの盗取などがあり得る。

A利用とAI構築の課題

AI保護はライフサイクルからアプローチ

こうしたリスクを検出し対策を行うには、AI利用のライフサイクルからのアプローチが重要だとドーア氏は指摘した。

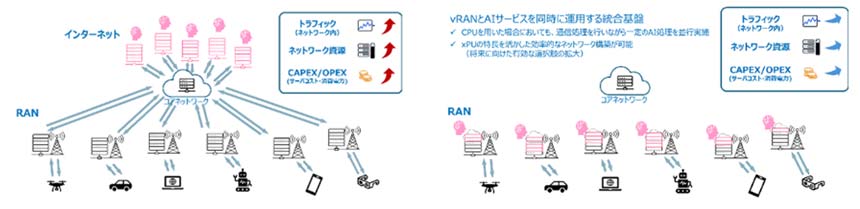

前者のAI利用に関しては、従業員が利用するAIを検出した後、ポリシーを設定し、それに沿った適切な利用が行われていることをモニタリングしなければならない。

AI保護のライフサイクルアプローチ

AI構築のケースにおいても、AIの検出が最初の重要なステップであることは変わらない。従業員が利用しているAIをすべて特定したうえで、脆弱性などの検証、AIアプリケーションの安全性評価を実施。そして、継続的なモニタリングを行う。

このライフサイクルに基づいたAI保護の機能を提供するのが、Tenableが新たに発表した「Tenable AI Exposure」だ。同社のサイバーエクスポージャー管理ソリューション「Tenable One」に追加するかたちで、2025年中に一般提供を開始する。