生成AIのカスタマイズにかかるコストを抜本的に削減し、低コスト運用を持続可能にする――。

これが、NTTが今回開発した「ポータブルチューニング」技術の目的だ。

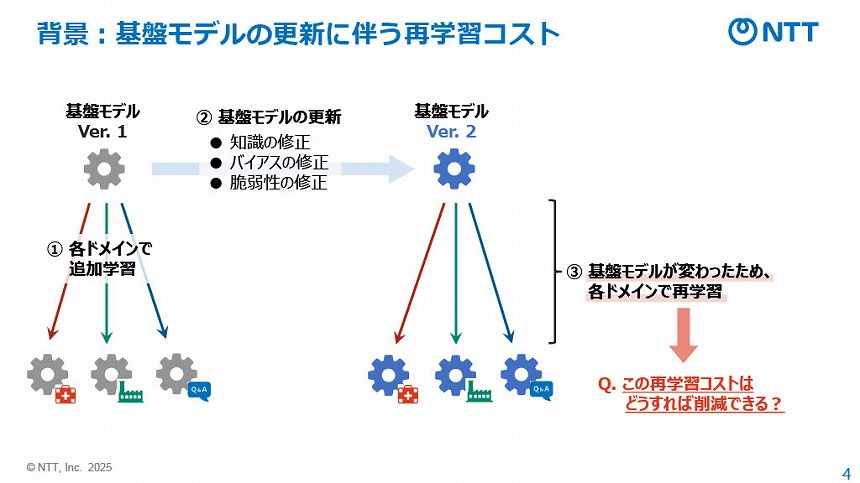

生成AIの基盤モデルはPCやサーバー等のOSと同様に、定期的なアップデートが不可欠だ。これは、知識の最新化や脆弱性の修正、学習データ/アルゴリズムの偏りによって生じるバイアスの修正といった観点から避けられない。だが、バージョンアップのたびにドメインやタスクごとに特化学習(ファインチューニング)をやり直す必要があるため(下図表)、これが生成AIを活用するにあたって大きなコストとなっている。

基盤モデルの更新に伴う再学習コスト

ポータブルチューニング技術は、バージョンアップのたびに必要なこの「再学習」を不要にする技術だ。

開発に携わったNTTコンピュータ&データサイエンス研究所 革新的コンピューティングアーキテクチャ研究プロジェクト 准特別研究員の千々和大輝氏は、2025年7月7日に開催したオンライン説明会で、その仕組みと利点について解説。一度目のバージョンアップ時には再学習が必要だが、その際の「学習過程を再利用することで、2回め以降の追加学習コストが基本的にゼロになる」という。

NTTコンピュータ&データサイエンス研究所 革新的コンピューティングアーキテクチャ研究プロジェクト 准特別研究員の千々和大輝氏

NTTが提案する新概念「学習転移」とは

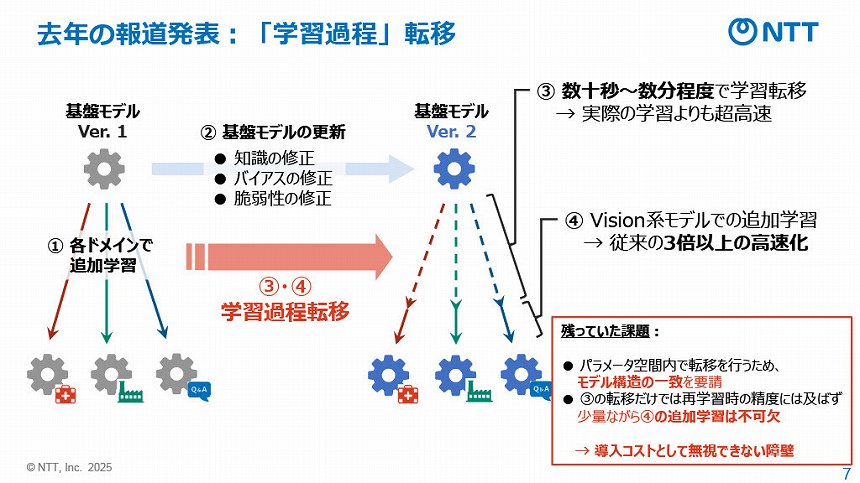

ポータブルチューニング技術は、NTTが提案する「学習過程転移」という新しい概念に基づくものだ。AIの学習効率を向上させる機械学習の手法に「転移学習」があるが、それとは「逆の概念」だと千々石氏は説明した。

学習過程転移(下図表)とは、基盤モデルを更新(Ver.1→Ver.2)した際に、Ver.1で行った追加学習の過程を、新しい基盤モデル(Ver.2)の上に移植し転換することで、追加学習をやり直すよりも高速かつ低コストにファインチューニングができるというものだ。Ver.1モデルの学習過程をVer.2が模倣するイメージである。

昨年発表した「学習過程転移」のイメージ

NTTは2024年5月にこの学習過程転移の概念を発表していたが、「2つの課題が残っていた」(千々石氏)。これを解決したのが今回発表した新技術だ。