AI/IoT時代を迎えて、ネットワークにつながるデバイスとやり取りされるデータ量は格段に増えた。この状況に、エヌビディアはどんな対応策を示すのか。シニアソリューションアーキテクトの大西宏之氏は、「エヌビディアはデータセンター(DC)自体を新しいコンピューティングユニットと捉え、“最適なネットワーク”という視点からソリューションを提案している」と話す。

エヌビディア シニアソリューションアーキテクトの大西宏之氏

エヌビディアはGPUメーカーのイメージが強く、同社のGPUはDCにおいて、AIや機械学習(ML)、ビデオ等のワークロードの高速化に貢献してきた。だが、それだけでは今後、さらなる需要の増大に応えるには限界がくる。

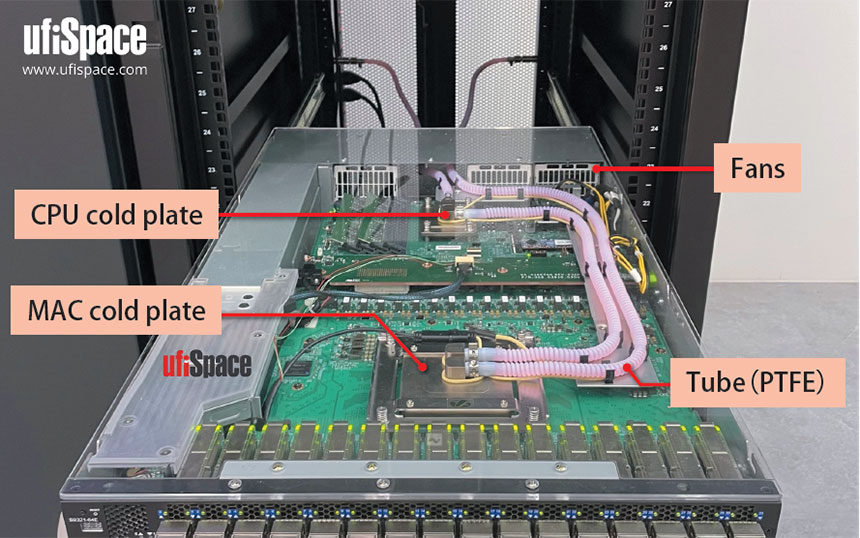

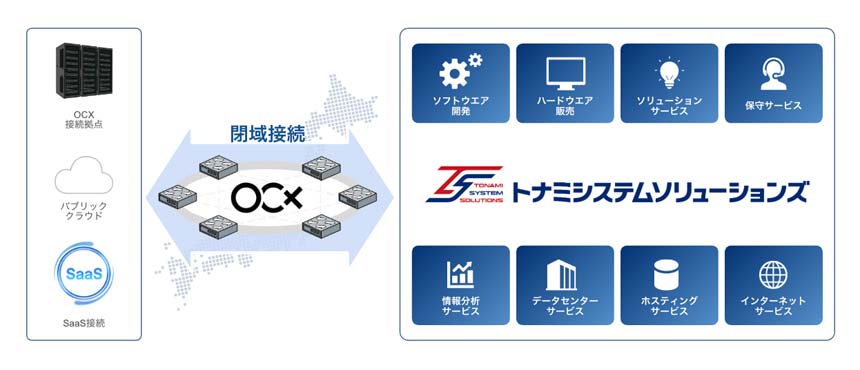

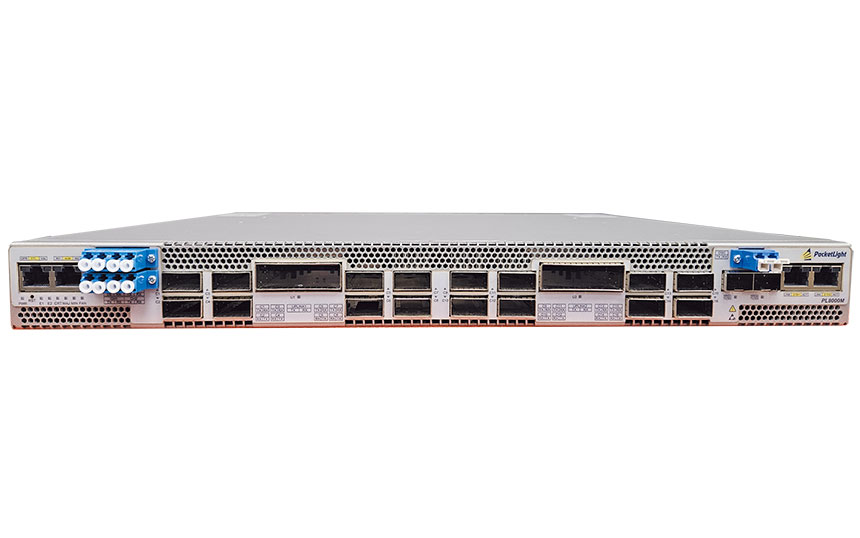

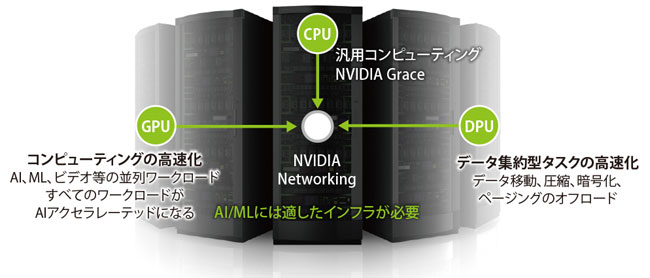

そこで同社が注力するのが、ネットワークだ。ネットワーク/セキュリティ処理を高速化する新プロセッシングユニット「NVIDIA DPU(データ プロセッシング ユニット)」をはじめ、ネットワークを含めた包括的なソリューションを準備。「AI/MLに適した新しいDCインフラ」を実現しようとしている(図表1)。

図表1 データセンターは新しいコンピューティングユニット

半導体のエヌビディアがネットワークに注力する理由エヌビディアはなぜネットワークに注力するのか。大西氏はその理由を、「AIやMLの処理をクラスターで行う場合、ノード間の通信をいかに効率的にするかがポイントだから」と語る。

AI/ML処理のパフォーマンスを高めるには2通りの方法がある。1つはコンピューティングユニットを高速にすること。もう1つは、それを並べて並列処理させることだ。後者については、1つのノード内でGPUとGPU間で通信する速度は4.8Tbps(第3世代NVLink)と非常に速い。

だが、ノード間で並列処理する場合の通信速度は1桁遅い。CPUとGPU間の速度は504.16Gbps(PCIe gen.4 x32 理論値)しかなく、ネットワークにいたっては、InfiniBandで200Gbps、イーサネットでは400Gbpsだ。「エヌビディアがネットワークベンダーを買収してきた理由はここにある。アプリを効率的に使うためには、大規模で高品質なネットワークをいかに簡単に作るかがポイントだ」(大西氏)

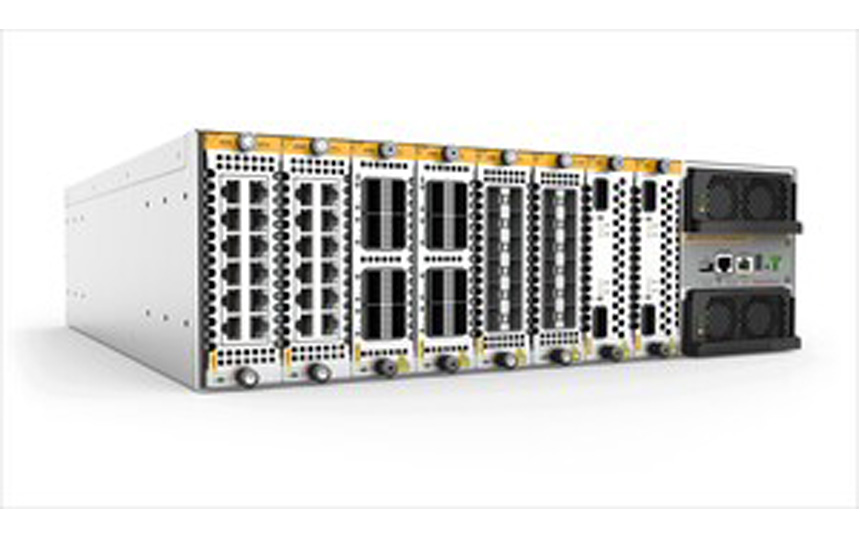

解決策として提供するソリューションの1つが「AIスイッチ」だ。「最大の特長は、非常に高性能なこと。パケット遅延の少なさは業界最高レベル。バッファの使い方も優れており、計算時間が圧倒的に短縮される」

その秘訣が、RoCEである。リモートダイレクトアクセス(RDMA)をイーサネットで実行する(over Converged Ethernet)機能であり、「こうした技術によって、アプリが安定的に稼働するネットワークが実現できる」。