ホワイトボックスで800GbE化

こうした構成でGPU専用ネットワークをスタートさせたLINEヤフーとAcpatioは早くも、GPUクラスターの拡張に着手し、非常に意欲的なチャレンジを始めている。800GbEへと広帯域化するに当たり、ホワイトボックススイッチの採用を決めたのだ。「安定性を重視した最初のGPU専用ネットワーク構築でノウハウが溜まった。LINEヤフーのインフラは元々マルチベンダーで、相互運用性を大事にしている。次期構成では新しいことにチャレンジしようと、Actapioとも議論した」(深澤氏)

LINEヤフーが予定するGPUクラスターの拡張は、ACP基盤に新世代GPUサーバーを追加導入するもので、現行の構成とは別にGPUネットワークを新設することになる。

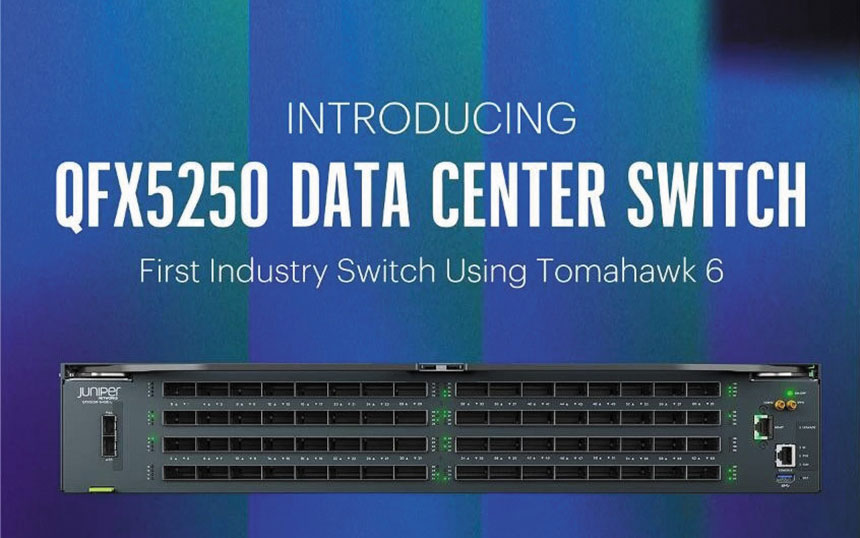

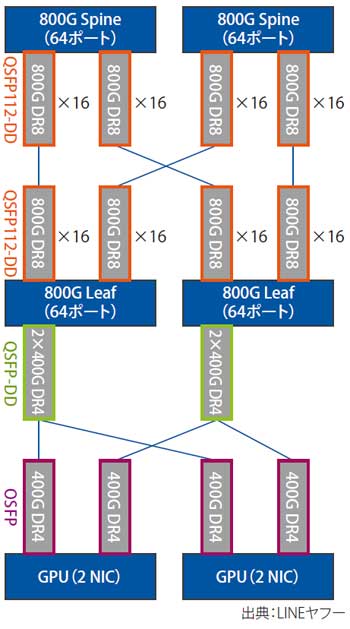

LeafとSpineに、台湾UfiSpace製の800GbE対応ホワイトボックススイッチを選定。ネットワークOSには米Arrcusの「ArcOS」を採用した。

LINEヤフーは元来、ハードウェアの仕様・設計をオープンソース化する「Open Compute Project(OCP)」のサーバーを導入・活用しており、フロントエンドネットワークでもArcOSの使用実績があった。そのArrcusからの提案が、「新しいことをやりたかった」メンバーの思いに合致したと北野氏は話す。

Arrcusが提案したのは、「800G×64ポートのスイッチを導入することで、従来の1台あたり400G×32構成よりもスイッチ台数とトランシーバーの数を減らす」というもの。複数のベンダーを検討した結果、コスト効果も大きなArrcus案を採用した。

「800GbEの商用稼働もArrcusは早く、コストも抑えられる点は強く刺さった」と立見氏。ネットワークの検証もすでにスタートしており、新GPUクラスターは2025年7月頃に稼働を開始する計画だ。

図表2 次期ネットワークの構成

自社製管理システムが運用の鍵

現行構成と新規のGPUクラスターで、ネットワークのハードウェアとソフトウェアが異なるため、運用複雑化も懸念されるが、大浦氏はその対策も充分と話す。LINEヤフーは、特定のベンダーが提供する管理システムに依存せず、「マルチベンダーに対応できるように、オープンソースや自社で作ったツールも組み合わせて管理システムを構築している」。どんなベンダーの機器/OSでも「差異なく運用できる体制を整えることで、ベンダー間の差異を吸収している」という。

インフラ構成管理ツールのAnsible等を用いた既存の管理プラットフォームに、新たにArcOSを追加するにあたってはArrcus側に機能追加等を依頼する場面もあるが、「そこもスピード感を持って対応していただけている。その対応力も評価して、800GbEの導入を決めた」と北野氏。ネットワークトポロジー等は基本的に現行構成を踏襲する。

このように、データセンター設備やネットワーキングも含めて、AIインフラをすべて自社で構築・運用するLINEヤフー。その経験を基に、ネットワークエンジニアへのアドバイスを聞いたところ、立見氏はこう話した。「ネットワークだけ見ていても、理解できない。RoCE自体の知識はもちろん、サーバー側のNICのパラメーターを調整するなど、広い知識が必要だ。ユーザーがどんな使い方をするのかも含めて理解して作るのでなければ、ネットワークができても、システムとして使えないということが起きる」

もちろん、1人のスーパーエンジニアがいる必要はない。様々な領域に精通したエンジニアが強みを出し合いながら協力する。新時代のAIインフラを実現するには、「そんなマインドが絶対的に必要」と強調する。