IEEEメンバーで情報セキュリティ大学院大学 教授の大塚玲氏。人工知能学会 安全性とセキュリティ研究会(SIG-SEC)主査、JNSA サイバーセキュリティ産学連携協議会 代表も務める

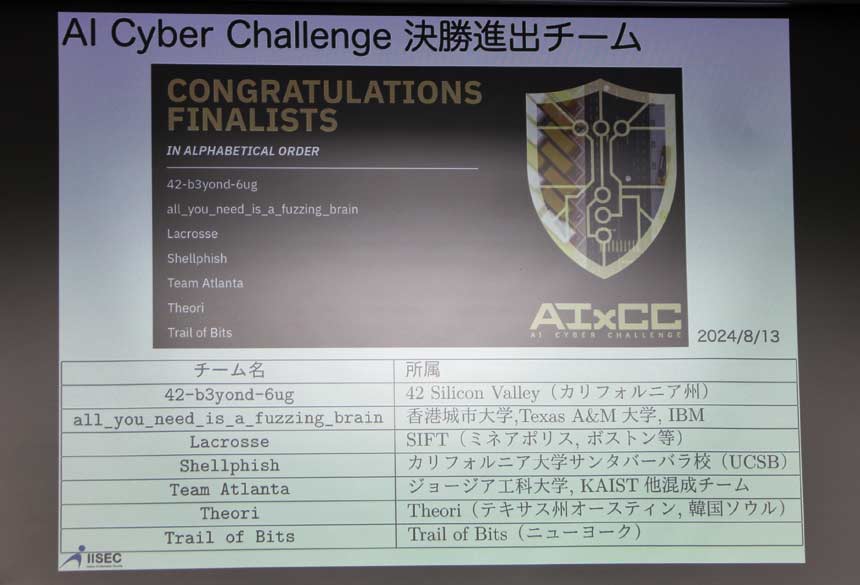

米国防省の研究部門で、インターネットの生みの親としても知られるDARPAは今年8月、ソフトウェア脆弱性の自動修正システム競技大会「AI Cyber Challenge」の準決勝を世界最高峰のセキュリティコンテスト「DEF CON 32」において開催した。

準決勝を勝ち抜いたのは7チーム。各チームにはそれぞれ200万ドルもの開発資金が与えられ、来年8月のDEF CON 33で行われる決勝戦に臨む。優勝賞金は400万ドル。2位にも300万ドル、3位にも150万ドルという高額な賞金が用意されている。大会をサポートするのは、生成AIをリードするAnthropic、グーグル、マイクロソフト、OpenAIの4社だ。

AI Cyber Challengeの決勝戦への進出を決めた7チーム

「アメリカの国防省も、AIを使って攻撃したり防御することに注目していると理解いただきたい」。情報セキュリティ大学院大学の大塚玲教授は、AI Cyber Challengeを一例に、AIをサイバー攻撃や防御に活用する「AI for Security」の取り組みが本格化していることを紹介した。