「世界中で、リアルタイムに処理されるAI推論が求められる時代になった」

アカマイ・テクノロジーズ プリンシパルメジャーアカウントエグゼクティブのデイビー チェン(Davy Chen)氏は、「Akamai Inference Cloud」提供の背景についてそう語った。

アカマイ・テクノロジーズ プリンシパルメジャーアカウントエグゼクティブのデイビー チェン(Davy Chen)氏

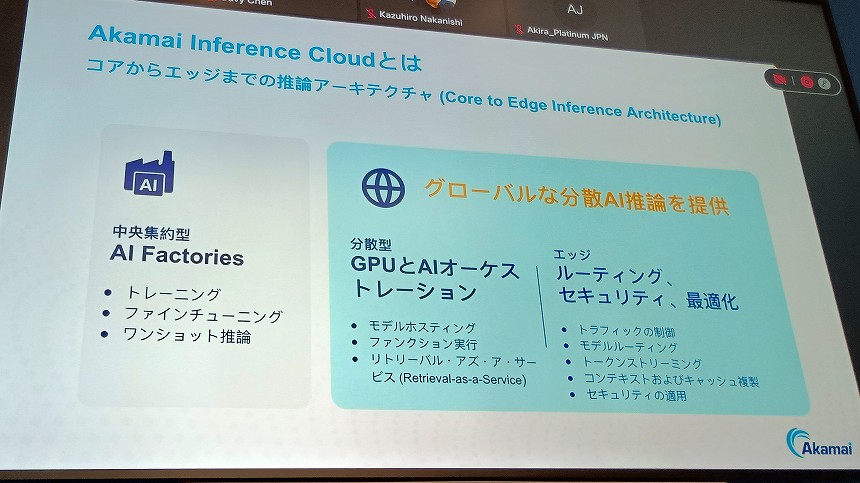

AI関連投資は、LLM(大規模言語モデル)などのAIモデルのトレーニングから、そのモデルを活用した「AI推論」のためのインフラ、仕組みづくりへとシフトしてきている。特に、自動運転やフィジカルAIといったリアルタイム性が求められる用途での需要が拡大すると同氏は予測。Akamai Inference Cloudは、エヌビディアと提携してそのニーズに応える基盤を構築するものだと説明した。

これは、ひと言でいえば、アカマイがCDNやセキュリティサービスを提供するために世界中に展開しているコンピューティング基盤に、AI推論のためのGPUサーバーを配備するものだ。その拠点数は4200拠点以上に及ぶ。ユーザーに近いエッジでAI推論を提供することで、リアルタイム性が求められるユースケースに対応する。

Akamai Inference Cloudの概要

クラウドに比べて「遅延は5分の1」

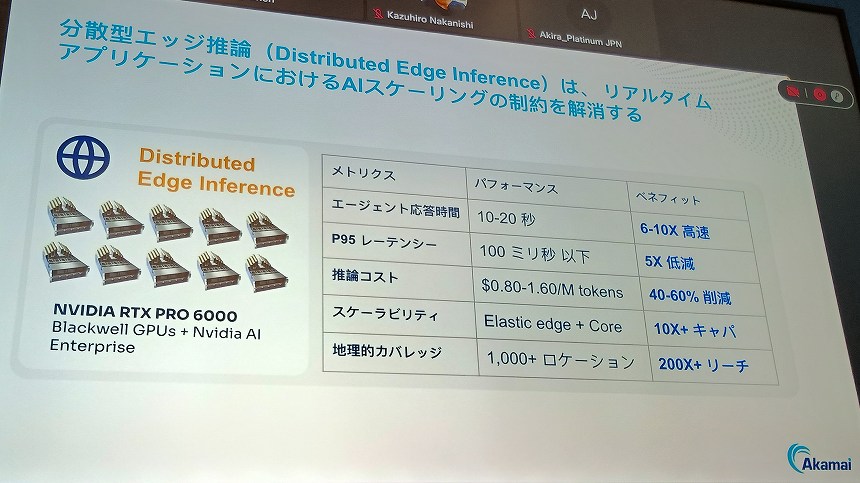

Akamai Inference Cloudの最大の価値は低遅延だ。チェン氏によれば、中央集約型のクラウドデータセンターでAI推論を行う場合と比べて、AIエージェントがユーザーのリクエストに応える「応答時間は6~10倍高速になり、遅延は5分の1になる」という。通信も含めたトータルコストは4~6割も削減が可能で、「持続可能なかたちでAI推論を地球規模にスケールさせることができる」と、その効果に自信を見せた。

クラウドとのパフォーマンス比較

このAI推論基盤は、GPUリソースだけでなく、AIモデルのデプロイや運用を行うオーケストレーション、トラフィックの制御やルーティング、セキュリティ等の機能も提供する。

まずは20拠点から展開を始めるが、すでに商用利用している事例もあるという。米国のスタートアップ、Monksだ。