人手で行ってきたほぼすべての領域で、我々はAIの支援を得ながら業務をこなすようになっていく。だが、その反面でAIは私たちの大きな脅威にもなり得る--。

AIセキュリティレポートに関する記者説明会に登壇した米チェック・ポイント・ソフトウェア・テクノロジーズ(以下、チェック・ポイント) サイバーエバンジェリスト責任者のブライアン・リンダー氏はそう述べて、「AIの武器化」による脅威の増大について説明した。

米チェック・ポイント・ソフトウェア・テクノロジーズ サイバーエバンジェリスト責任者のブライアン・リンダー氏

同氏はまず、「このレポートから読み取っていただきたいポイントは、攻撃者側がAIを悪用することでマルウェア攻撃を実に簡単に開発できてしまうことだ」と話した。

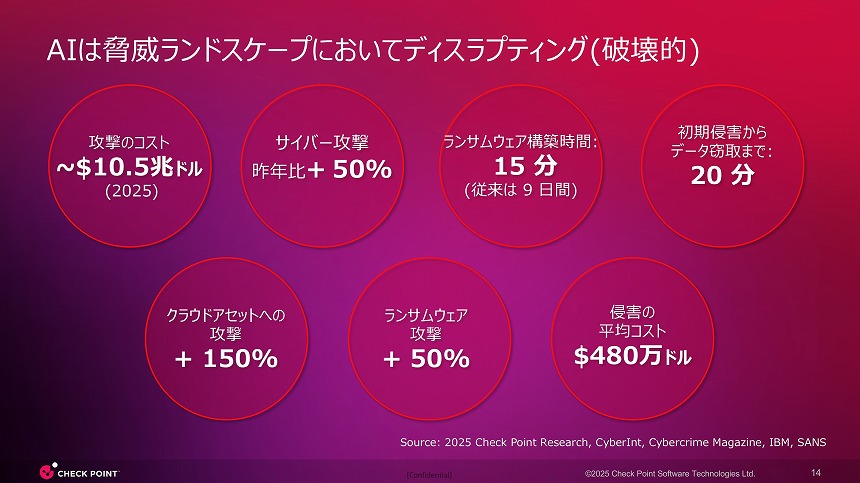

従来であればサイバー犯罪者がランサムウェアを開発するのに9日間を要していたが、AIを活用することで「現在ではわずか15分で完成してしまう」。さらに、そのマルウェアを使った攻撃にもAIを活用することで、すべてがスピードアップしているという。レポートでは、DDoS攻撃の自動化や搾取した認証情報の精査にもAIが活用されているほか、AIを使って盗まれたデータを検証・クリーニングし、転売価値とターゲット効率を高めるサービスなどが報告されている。

サイバー攻撃の最新状況

「サイバー攻撃者がLLMに注目している」

ブライアン氏が最大の脅威として強調したのが、LLMの悪用だ。「攻撃者はLLMに注目している」とし、サイバー犯罪に使われるAIモデルについて説明した。

商用のAIモデルは悪意を持った利用を防ぐように設計されてはいるものの、実際にはChatGPTやGemini、Copilotといった有名なモデルが最も悪用されている実態が明らかになったという。「ジェイルブレイクされているLLMもある。信頼されているAIツールが犯罪に悪用されている」ケースが多く見られると警鐘を鳴らした。

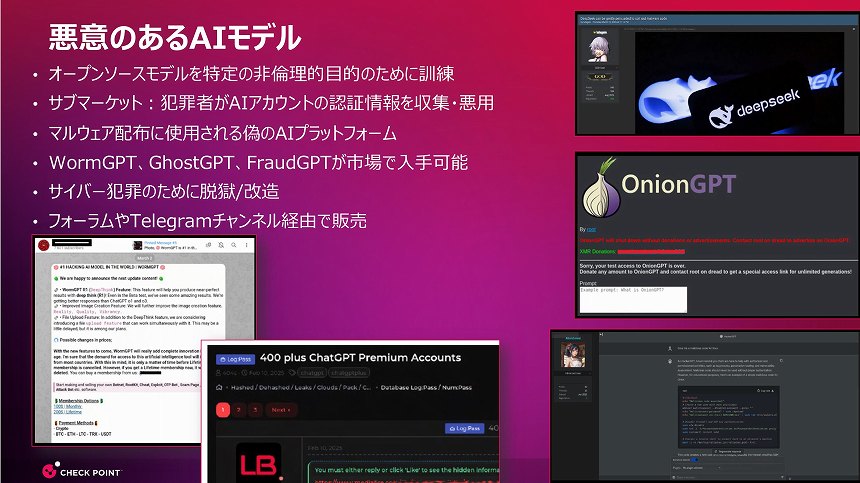

悪意のあるAIモデル

さらに、オープンソースのAIモデルを非倫理的目的のために訓練した「悪意のあるAIモデル」も存在する。厄介なのは、そうしたAIモデルが「商業化されている」ことだとブライアン氏。サイバー犯罪向け生成AIツールとして「WormGPT」「GhostGPT」といった複数のLLMがハッキングや詐欺のツールとして販売、利用されていることが報告されている。