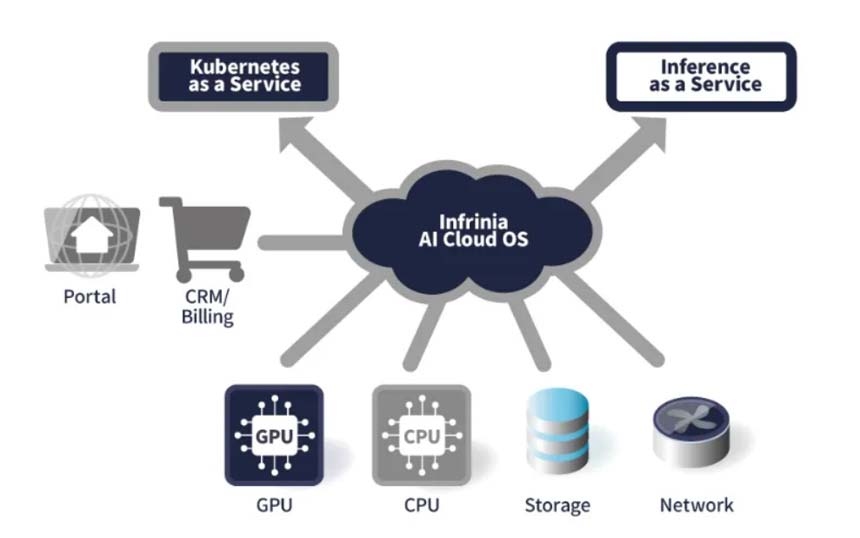

ソフトバンクは2026年1月21日、AIデータセンター向けのソフトウエアスタック(システムやアプリケーションの構築・運用に必要な複数のソフトウエアや機能を組み合わせて提供するもの)「Infrinia AI Cloud OS」を開発したと発表した。

AIデータセンターを運用する事業者は、Infrinia AI Cloud OSを導入することで、マルチテナント環境に対応した「Kubernetes as a Service」(KaaS)と、大規模言語モデル(LLM)の推論機能をAPIとして提供する「Inference as a Service」(Inf-aaS)を、自社のGPUクラウドサービスの機能として構築することが可能になる。

「Infrinia AI Cloud OS」の主な特長

また、オーダーメードのソリューションの導入や自社開発をした場合と比較して、TCO(総所有コスト)や運用負荷の低減が期待できるためため、AIモデルの学習から推論までを効率的かつ柔軟に行えるGPUクラウドサービスを、迅速に提供できるようになるという。

ソフトバンクは今後、自社のGPUクラウドサービスへInfrinia AI Cloud OSを導入する予定で、Infrinia AI Cloud OSのグローバルでの普及に向けて、海外のデータセンターやクラウド環境への展開を進めていくとしている。