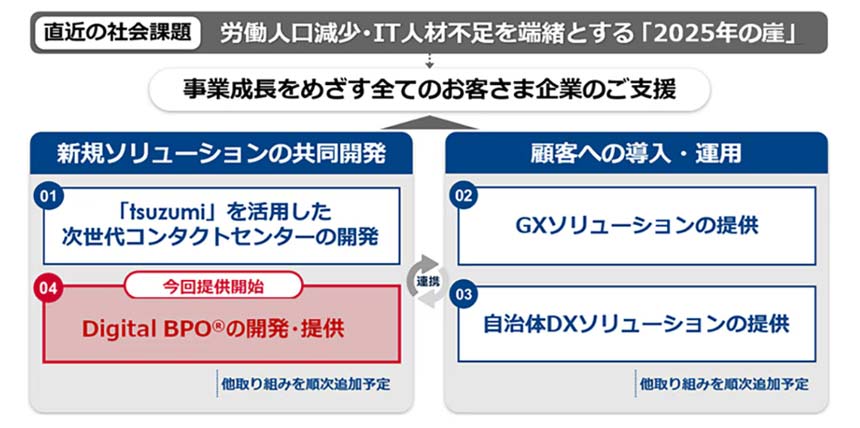

NTTコミュニケーションズ(NTT Com)とトランスコスモスは2025年4月28日、昨年締結した戦略的事業提携に基づき、「Digital BPO」ソリューションを提供開始したと発表した。

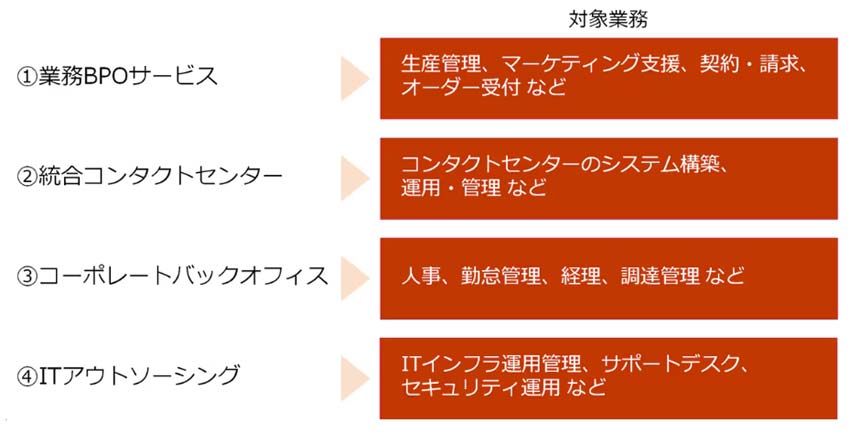

具体的には、顧客の業務プロセスをデジタル化・自動化・最適化する「業務BPOサービス」を展開する。例えば、顧客の営業活動や販売管理などで発生する各種帳票のエントリー作業の自動化から、顧客の独自ルールに沿った査定・評価など、後工程業務の自動化までを見据えたサービスを実現する。

そのほか、コンタクトセンターの運営に必要なシステムを構築する「統合コンタクトセンター」サービス、人事・経理・調達管理など間接業務のペーパーレス化・自動化を支援する「コーポレートバックオフィス」サービス、ITインフラ・ヘルプデスク・セキュリティ対策などに係るIT環境を一元的に提供する「ITアウトソーシング」サービスを用意する。