NTTと産業技術総合研究所(産総研)は2025年10月21日、道路陥没リスクの早期発見に向け、光ファイバーを用いた地盤モニタリングの実証に成功したと発表した。

都市部では、老朽化した上下水道などのインフラに土砂が流入し、地中空洞が発生する事件が社会問題となっている。今年1月に埼玉・八潮で発生した道路陥没事故のように、地中空洞は交通障害やライフラインの寸断を招くだけでなく、人命に関わる重大事故にもつながりかねない。

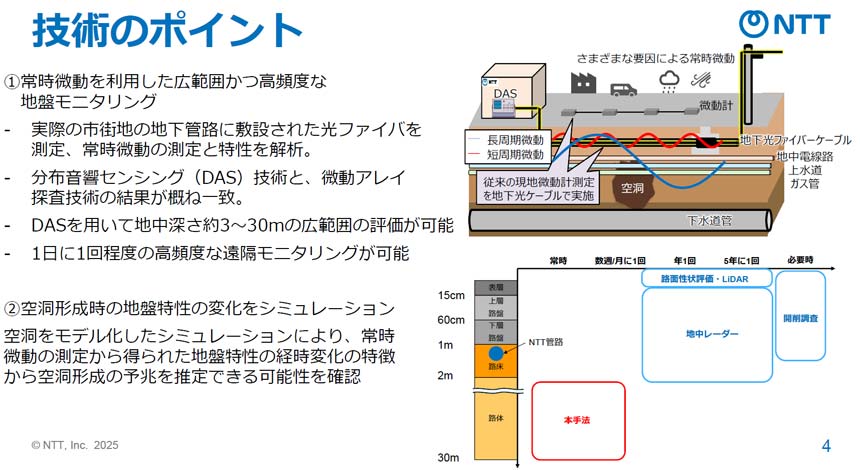

こうした道路陥没事故を防ぐため、現在も地中レーダーや超音波などを用いた地中空洞調査が行われているが、「現地への人員派遣が必要で、道路も一時的に封鎖しなければならず、高い頻度での点検が難しい。調査できる深度も地表から3m未満と限定的だ」とNTTアクセスサービスシステム研究所 アクセス運用プロジェクト 主任研究員の飯田大輔氏は指摘した。

そこで両者は、従来の地中空洞調査が抱える課題を解消するため、光ファイバーセンシングを活用して地中空洞を推定する手法を実証。これにより、現地調査を行わずに、地中約3~30mの深さを高頻度で監視できるようになったという。

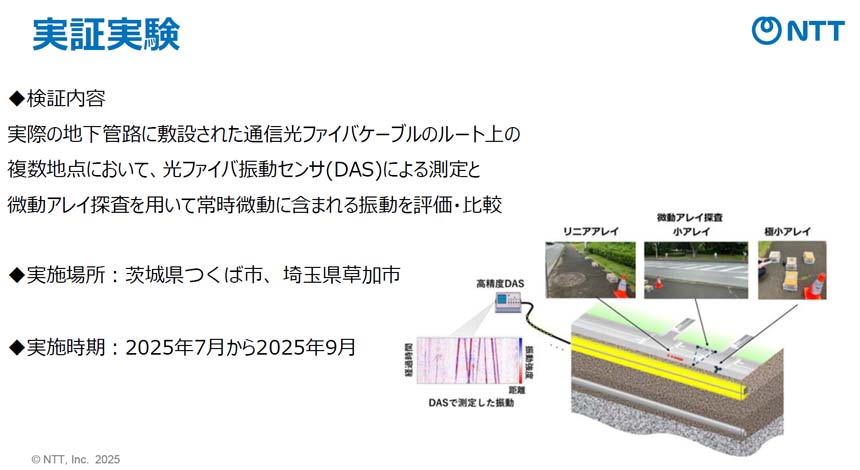

今回の実証では、実際の地下管路に敷設された光ファイバーケーブルのルート上の複数地点において、光ファイバー振動センサー(DAS)を用いた常時微動の測定・検知を行った。DASとは、光ファイバーそのものをセンサーとして利用し、周囲の微小な振動や音響を高密度に検知・計測する技術である。

また、比較用に「微動アレイ探査」と呼ばれる手法による調査も行った。微動アレイ探査は、複数の高感度地震計(微動計)を設置し、人がほとんど感じないレベルの常時微動を捉えることで、地下数十メートルまで調査する手法である。実証は2025年7月~9月にかけて、茨城・つくば市と埼玉・草加市で実施した。